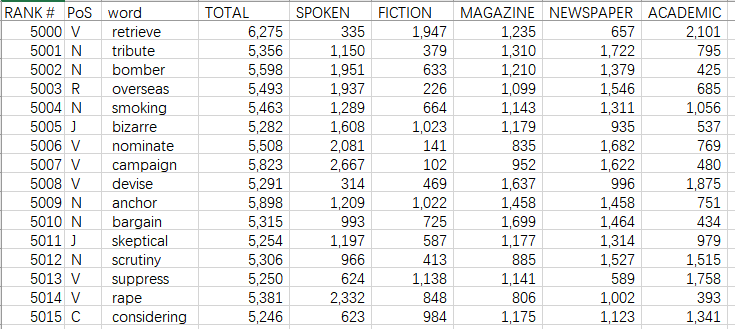

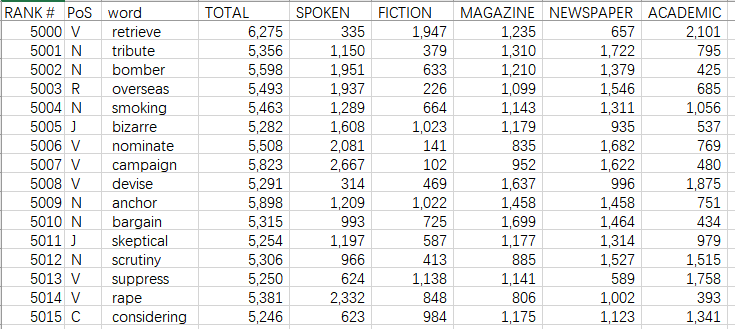

数据源为 coca词频表,共6万词,其中包含了每个词的词频,按词频从大到小排列。于是在excel中用了几个简单的函数做统计,计算出,在实际应用中,如果到达到一定百分比的认识率,需要多少词汇量。当然,这并不很准确,但即便如此还是有参考意义的。

原始数据表示例

[……]

这是fengyqf的博客

本文原本写在上篇《中文汉字输入法的记忆》的一部分,草稿状态放了一个多月都没续写,于 2025/08/21 独立出来,作为五笔输入法的使用记录吧,遇到的问题、相应尝试、解决方案。

按回忆曾主力使用过的几款五笔输入法如下:

海峰五笔,极点五笔,极品五笔,搜狗五笔,QQ五笔,花儿五笔,Windows 10五笔

印象中基本上都是因为软件不兼容而更换的,也有过新版本发布后再用回去的。截止当前,主力使用 Windows 10五笔,虽然仍有不少缺陷,但多少也在缓慢的一点点改进着,更重要的是没有严重兼容问题,比较省心。

真正的学习五笔是从拥有自己的电脑开始,在那之前主要用的是智能ABC[……]

这篇并不算是技术文章,只是一段记忆与偶发的感想。

时间已进入2025年的下半年,使用Windows 10自带的输入法打出来的英文字母又成了全角,这是老问题,只因为按到了这个选项的快捷,但是老记不住,试了半天都不对,于是求助于搜索引擎才得解,Shif+空格。正在使用的是Windows 10自带的五笔输入法,一直感觉有点简陋,但找个输入法是件相当困难的事情。

回想最初接触电脑是初三,应该是1999年底或者2000年初,那还是第一节计算机课之前,学校新新建起来的机房里,跟别人偷偷溜进去胡乱捣鼓了一通,完全不记得都操作了什么,恐怕连英文打字都不知道,更不用说中文输入了,只模糊的记得在Win[……]

Windows 下,有时要频繁的对一个目录做备份,这个目录并不大(比如几个或十几个小文件,1MB以下),只在需要的时候才监测并做定期备份,与上次备份以来没有修改则不备份。

一个实际场景是,某些单机游戏,游戏本身会自动保存数据,万一某一步手抖误操作,想退回以前存档,结果发现很长时间没有手工存档,那么这期间的时间就浪费了。如果自动把存档目录备份起来,就可以方便的回退到最合理的历史时间点。

windows本身的卷影复制、第三方自动备份程序、同步备份到远程服务器,等很多方案都可以实现。只是,安装个庞大的程序显得小题大作,这里希望使用尽量简单的工具实现,于是选用批处理脚[……]

bat批处理这东西非常古老了,使用也不多,但在一些简单任务上,还是个不错的可选项,然而坑实在不少。

setlocal enabledelayedexpansion, 设置本地为启用延迟扩展,关键点是如下的原理:

批处理读取命令时是按行读取的(另外例如for命令等,其后用一对圆括号闭合的所有语句也当作一行),在处理之前要完成必要的预处理工作,这其中就包括对该行命令中的变量赋值。

这很坑,一不留神就中招,还一时半会儿看不出原因。

参看 https://www.cnblogs.com/ydhliphonedev/arc[……]

这些都只不过是曾经的美好,也或许未必是真的美好,而是记忆的光环加持所致。

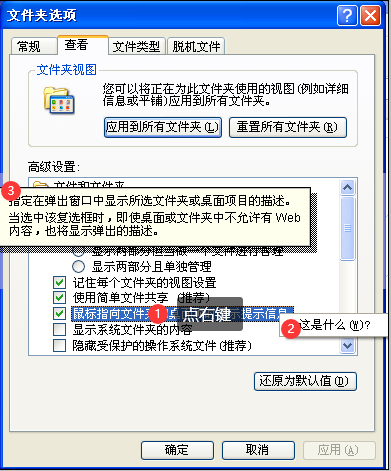

很多对话框里,都可以随处点右键看到一个“这是什么?…”的提示,点之得到一段简明的提示文字,对不熟悉的功能,那是相当好用,而在时下的windows10里,应该是完全没有了(似乎是label控件的一个属性,已经不再支持了)。事实上,windows10里的很多上下文帮助也是残废的,多是一个到微软官方网站的链接,而链接页面也经常是无厘头的,甚至死链接。

印象中,以前的计算机基础教材(主要是windows 2000基础教学篇)里,还专门讲了这个功能。

数据源为 coca词频表,共6万词,其中包含了每个词的词频,按词频从大到小排列。于是在excel中用了几个简单的函数做统计,计算出,在实际应用中,如果到达到一定百分比的认识率,需要多少词汇量。当然,这并不很准确,但即便如此还是有参考意义的。

原始数据表示例

[……]

windows xp 可以在文件夹选项中为每种扩展名的文件自定义设置图标,但在 windows 10/11 下没有了相关工功能(也包括win7),要想修改文件的图标,只能通过第三方工具(如 FileTypesMan )实现,或者手工修改注册表。

FileTypesMan 是一款免费软件,【FileTypesMan v2.00 – File Types Manager for Windows Copyright (c) 2008 – 2024 Nir Sofer】

其作者网站上有下载,操作界面默认为英文,同时也有中文语言包(Simplified C[……]

WordPress站点改用了GeneratePress主题,使用起来感觉还不错,但发现有一些问题,做了针对性的补丁,记录于此

后台编辑器样式方面,预格式化区域<pre>…</pre>没有与前台显示一致,这不得于可视化编辑,所以做了简单的补丁。另外,因为习惯上把代码写在 <pre> … </pre>中,多加一行定义等宽字体。(对应后面的修改项1)

发现在某些 windows 10上, 字母 a, s 中间部分线条诡异得粗,很不谐调。

应该是因为字[……]

WordPress站点启用CDN,其实就是切换图片、CSS等元素的URL到CDN域名,这要通过插件实现。官方扩展市场里很多相关插件,但都过于庞大,尤其多数都是集成在大型插件里面的小功能。 CDN Enabler 应该是最轻量级的件了,它本身也是一家CDN服务商的配套插件。插件本身的说明如下

The WordPress CDN Enabler plugin is a content delivery network (CDN) integration plugin that rewrites URLs, such as those serving CSS, JavaScript, and[……]

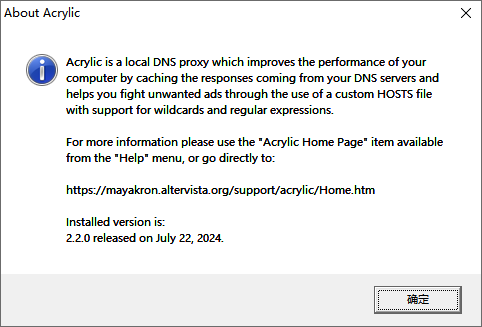

Acrylic DNS Proxy, 其官网为 https://mayakron.altervista.org/support/acrylic/Home.htm ,是适用于 Windows 的本地 DNS 代理服务器,它通过缓存来自 DNS 服务器的响应来提高计算机的性能,并可通过自定义 HOSTS 文件抵御不需要的广告,该文件经过优化,可处理数十万个域名,并支持通配符和正则表达式。支持 UDP,TCP,SOCKS5,DOH (DNS-over-HTTPS) 等多种DNS协议。

推荐下载便捷版(Portable for Windows),解压缩到合适的目录里(比如 D:\[……]